详解Pytorch显存动态分配规律探索

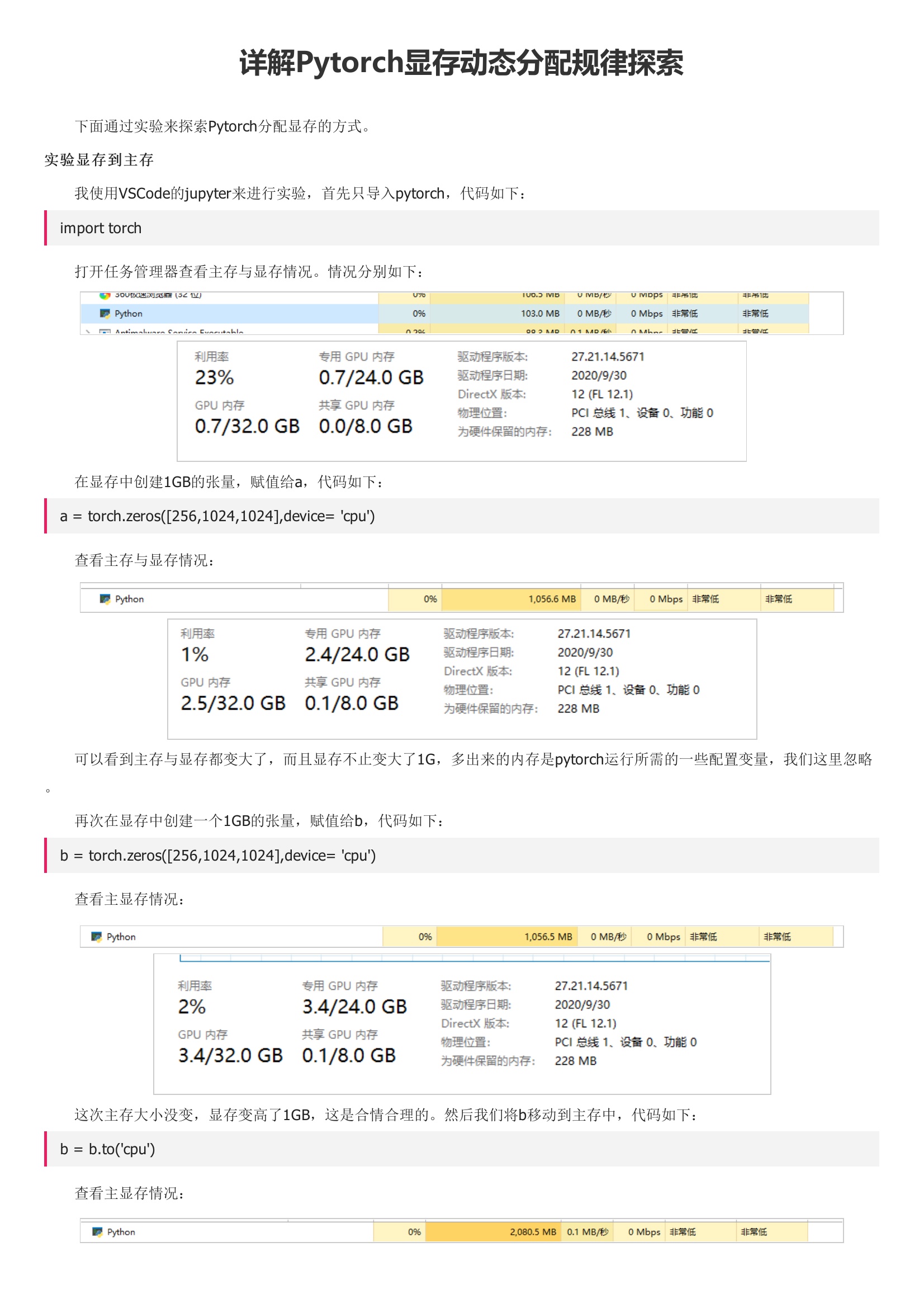

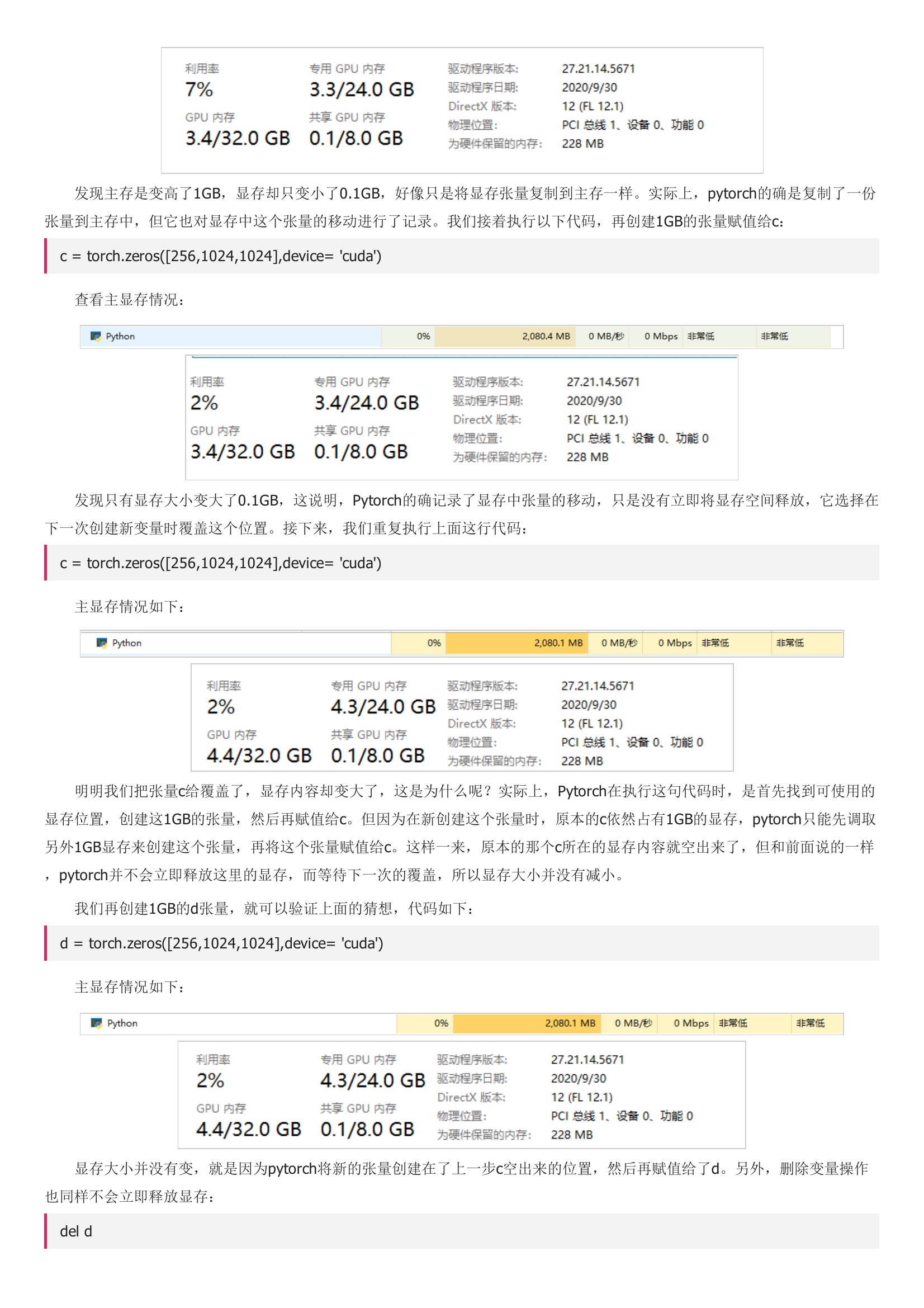

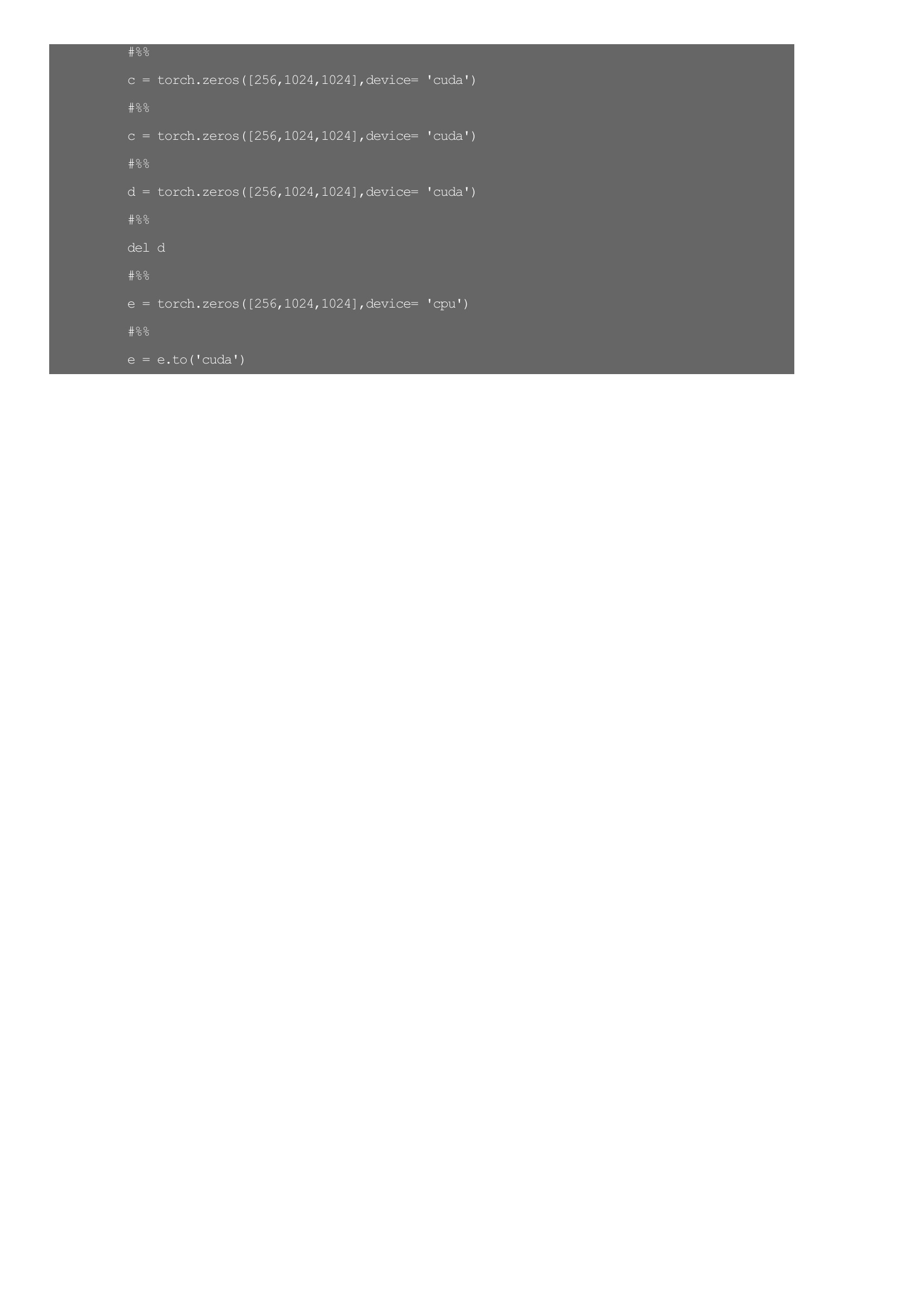

下面通过实验来探索Pytorch分配显存的方式。 我使用VSCode的jupyter来进行实验,首先只导入pytorch,代码如下:。 打开任务管理器查看主存与显存情况。情况分别如下: 在显存中创建1GB的张量,赋值给a,代码如下:。 查看主存与显存情况: 可以看到主存与显存都变大了,而且显存不止变大了1G,多出来的内存是pytorch运行所需的一些配置变量,我们这里忽略。但因为在新创建这个张量时,原本的c依然占有1GB的显存,pytorch只能先调取另外1GB显存来创建这个张量,再将这个张量赋值给c。 主显存情况: 显存没有变化,同样是等待下一次的覆盖。 通过上面的实验,我们了解到,pytorch不会立即释放显存中失效变量的内存,它会以覆盖的方式利用显存中的可用空间。