《Python爬虫开发与项目实战》 目录如下

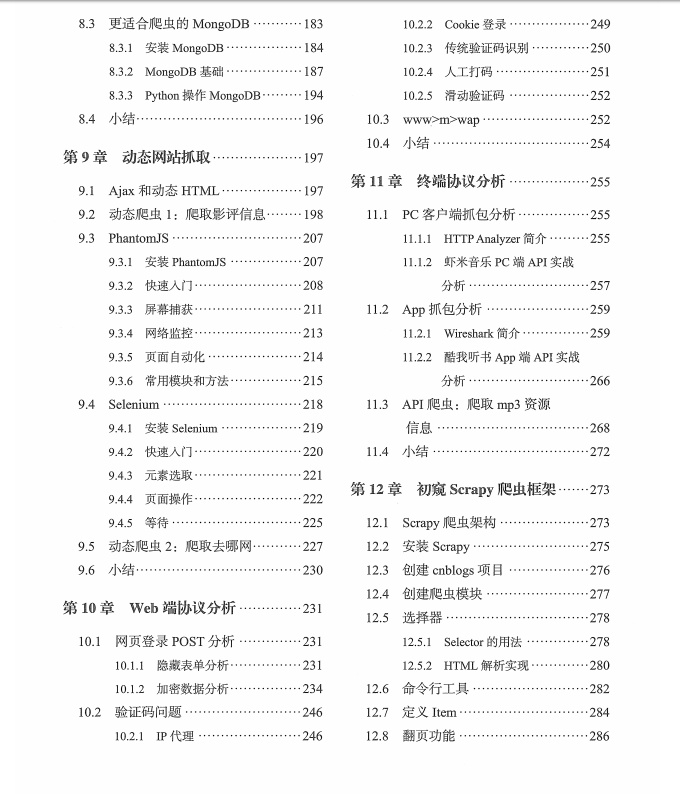

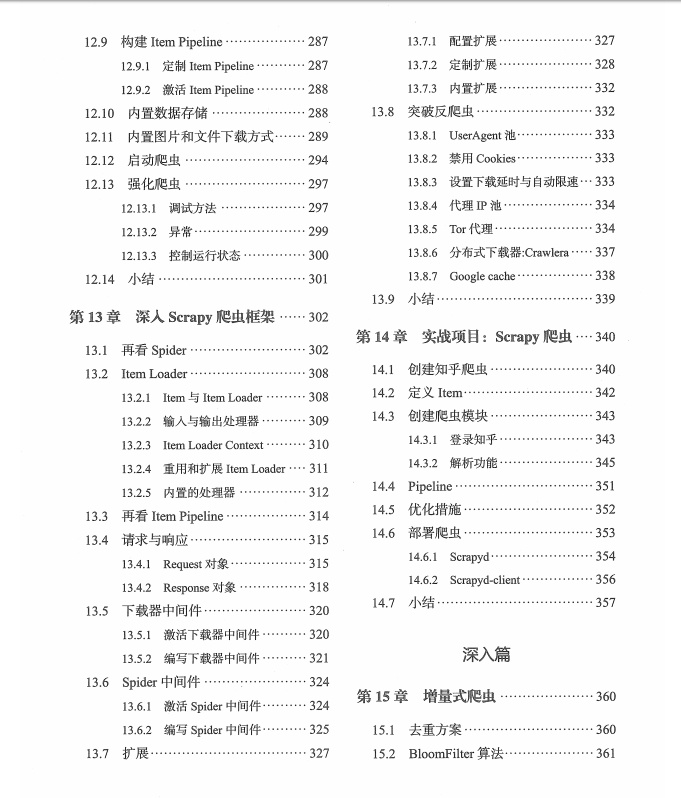

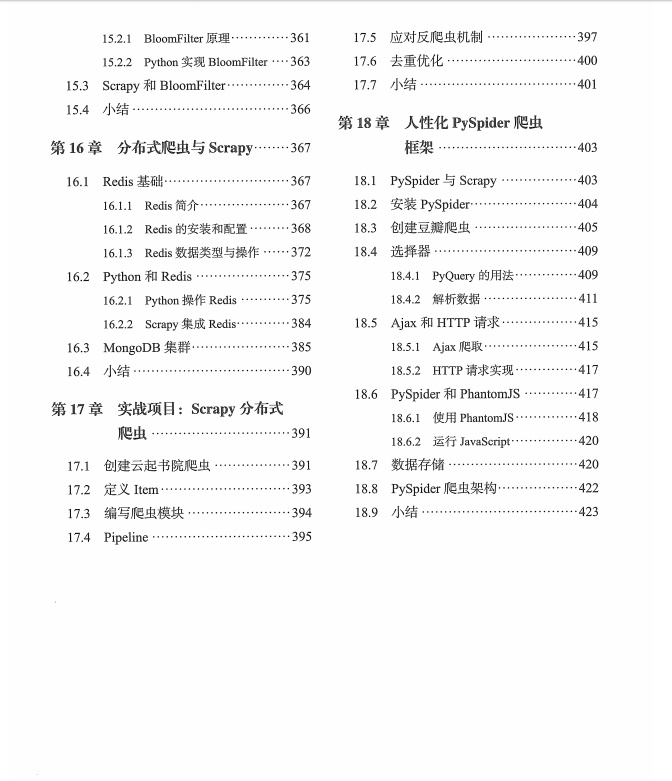

前言基础篇第1章 回顾Python编程21.1 安装Python21.1.1 Windows上安装Python21.1.2 Ubuntu上的Python31.2 搭建开发环境41.2.1 Eclipse PyDev41.2.2 PyCharm101.3 IO编程111.3.1 文件读写111.3.2 操作文件和目录141.3.3 序列化操作151.4 进程和线程161.4.1 多进程161.4.2 多线程221.4.3 协程251.4.4 分布式进程271.5 网络编程321.5.1 TCP编程331.5.2 UDP编程351.6 小结36第2章 Web前端基础372.1 W3C标准372.1.1 HTML372.1.2 CSS472.1.3 JavaScript512.1.4 XPath562.1.5 JSON612.2 HTTP标准612.2.1 HTTP请求过程622.2.2 HTTP状态码含义622.2.3 HTTP头部信息632.2.4 Cookie状态管理662.2.5 HTTP请求方式662.3 小结68第3章 初识网络爬虫693.1 网络爬虫概述693.1.1 网络爬虫及其应用693.1.2 网络爬虫结构713.2 HTTP请求的Python实现723.2.1 urllib2/urllib实现723.2.2 httplib/urllib实现763.2.3 更人性化的Requests773.3 小结82第4章 HTML解析大法834.1 初识Firebug834.1.1 安装Firebug844.1.2 强大的功能844.2 正则表达式954.2.1 基本语法与使用964.2.2 Python与正则1024.3 强大的BeautifulSoup1084.3.1 安装BeautifulSoup1084.3.2 BeautifulSoup的使用1094.3.3 lxml的XPath解析1244.4 小结126第5章 数据存储(无数据库版)1275.1 HTML正文抽取1275.1.1 存储为JSON1275.1.2 存储为CSV1325.2 多媒体文件抽取1365.3 Email提醒1375.4 小结138第6章 实战项目:基础爬虫1396.1 基础爬虫架构及运行流程1406.2 URL管理器1416.3 HTML下载器1426.4 HTML解析器1436.5 数据存储器1456.6 爬虫调度器1466.7 小结147第7章 实战项目:简单分布式爬虫1487.1 简单分布式爬虫结构1487.2 控制节点1497.2.1 URL管理器1497.2.2 数据存储器1517.2.3 控制调度器1537.3 爬虫节点1557.3.1 HTML下载器1557.3.2 HTML解析器1567.3.3 爬虫调度器1577.4 小结159中级篇第8章 数据存储(数据库版)1628.1 SQLite1628.1.1 安装SQLite1628.1.2 SQL语法1638.1.3 SQLite增删改查1688.1.4 SQLite事务1708.1.5 Python操作SQLite1718.2 MySQL1748.2.1 安装MySQL1748.2.2 MySQL基础1778.2.3 Python操作MySQL1818.3 更适合爬虫的MongoDB1838.3.1 安装MongoDB1848.3.2 MongoDB基础1878.3.3 Python操作MongoDB1948.4 小结196第9章 动态网站抓取1979.1 Ajax和动态HTML1979.2 动态爬虫1:爬取影评信息1989.3 PhantomJS2079.3.1 安装PhantomJS2079.3.2 快速入门2089.3.3 屏幕捕获2119.3.4 网络监控2139.3.5 页面自动化2149.3.6 常用模块和方法2159.4 Selenium2189.4.1 安装Selenium2199.4.2 快速入门2209.4.3 元素选取2219.4.4 页面操作2229.4.5 等待2259.5 动态爬虫2:爬取去哪网2279.6 小结230第10章 Web端协议分析23110.1 网页登录POST分析23110.1.1 隐藏表单分析23110.1.2 加密数据分析23410.2 验证码问题24610.2.1 IP代理24610.2.2 Cookie登录24910.2.3 传统验证码识别25010.2.4 人工打码25110.2.5 滑动验证码25210.3 www]m]wap25210.4 小结254第11章 终端协议分析25511.1 PC客户端抓包分析25511.1.1 HTTP Analyzer简介25511.1.2 虾米音乐PC端API实战分析25711.2 App抓包分析25911.2.1 Wireshark简介25911.2.2 酷我听书App端API实战分析26611.3 API爬虫:爬取mp3资源信息26811.4 小结272第12章 初窥Scrapy爬虫框架27312.1 Scrapy爬虫架构27312.2 安装Scrapy27512.3 创建cnblogs项目27612.4 创建爬虫模块27712.5 选择器27812.5.1 Selector的用法27812.5.2 HTML解析实现28012.6 命令行工具28212.7 定义Item28412.8 翻页功能28612.9 构建Item Pipeline28712.9.1 定制Item Pipeline28712.9.2 激活Item Pipeline28812.10 内置数据存储28812.11 内置图片和文件下载方式28912.12 启动爬虫29412.13 强化爬虫29712.13.1 调试方法29712.13.2 异常29912.13.3 控制运行状态30012.14 小结301第13章 深入Scrapy爬虫框架30213.1 再看Spider30213.2 Item Loader30813.2.1 Item与Item Loader30813.2.2 输入与输出处理器30913.2.3 Item Loader Context31013.2.4 重用和扩展Item Loader31113.2.5 内置的处理器31213.3 再看Item Pipeline31413.4 请求与响应31513.4.1 Request对象31513.4.2 Response对象31813.5 下载器中间件32013.5.1 激活下载器中间件32013.5.2 编写下载器中间件32113.6 Spider中间件32413.6.1 激活Spider中间件32413.6.2 编写Spider中间件32513.7 扩展32713.7.1 配置扩展32713.7.2 定制扩展32813.7.3 内置扩展33213.8 突破反爬虫33213.8.1 UserAgent池33313.8.2 禁用Cookies33313.8.3 设置下载延时与自动限速33313.8.4 代理IP池33413.8.5 Tor代理33413.8.6 分布式下载器:Crawlera33713.8.7 Google cache33813.9 小结339第14章 实战项目:Scrapy爬虫34014.1 创建知乎爬虫34014.2 定义Item34214.3 创建爬虫模块34314.3.1 登录知乎34314.3.2 解析功能34514.4 Pipeline35114.5 优化措施35214.6 部署爬虫35314.6.1 Scrapyd35414.6.2 Scrapyd-client35614.7 小结357深入篇第15章 增量式爬虫36015.1 去重方案36015.2 BloomFilter算法36115.2.1 BloomFilter原理36115.2.2 Python实现BloomFilter36315.3 Scrapy和BloomFilter36415.4 小结366第16章 分布式爬虫与Scrapy36716.1 Redis基础36716.1.1 Redis简介36716.1.2 Redis的安装和配置36816.1.3 Redis数据类型与操作37216.2 Python和Redis37516.2.1 Python操作Redis37516.2.2 Scrapy集成Redis38416.3 MongoDB集群38516.4 小结390第17章 实战项目:Scrapy分布式爬虫39117.1 创建云起书院爬虫39117.2 定义Item39317.3 编写爬虫模块39417.4 Pipeline39517.5 应对反爬虫机制39717.6 去重优化40017.7 小结401第18章 人性化PySpider爬虫框架40318.1 PySpider与Scrapy40318.2 安装PySpider40418.3 创建豆瓣爬虫40518.4 选择器40918.4.1 PyQuery的用法40918.4.2 解析数据41118.5 Ajax和HTTP请求41518.5.1 Ajax爬取41518.5.2 HTTP请求实现41718.6 PySpider和PhantomJS41718.6.1 使用PhantomJS41818.6.2 运行JavaScript42018.7 数据存储42018.8 PySpider爬虫架构42218.9 小结423

暂无评论