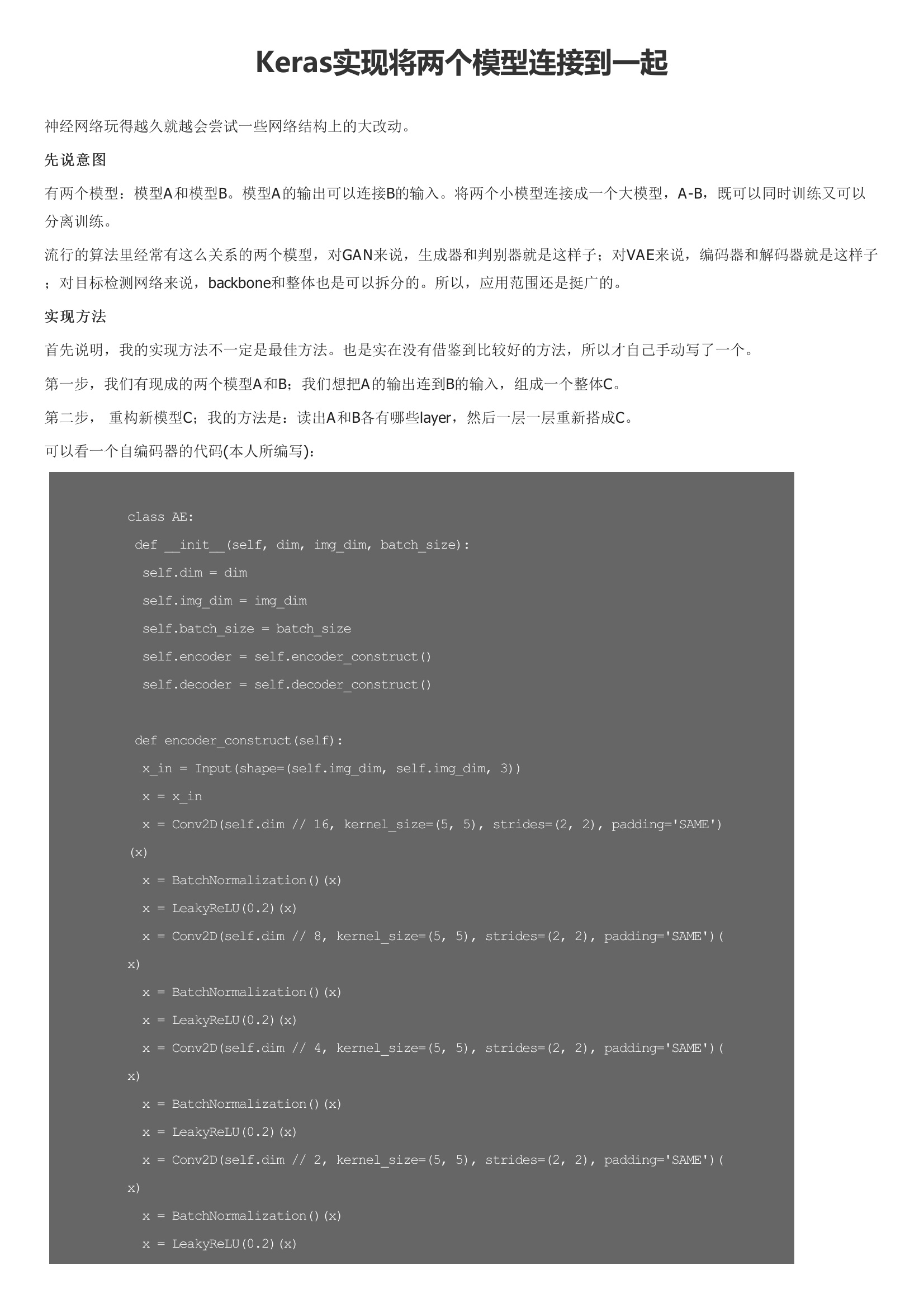

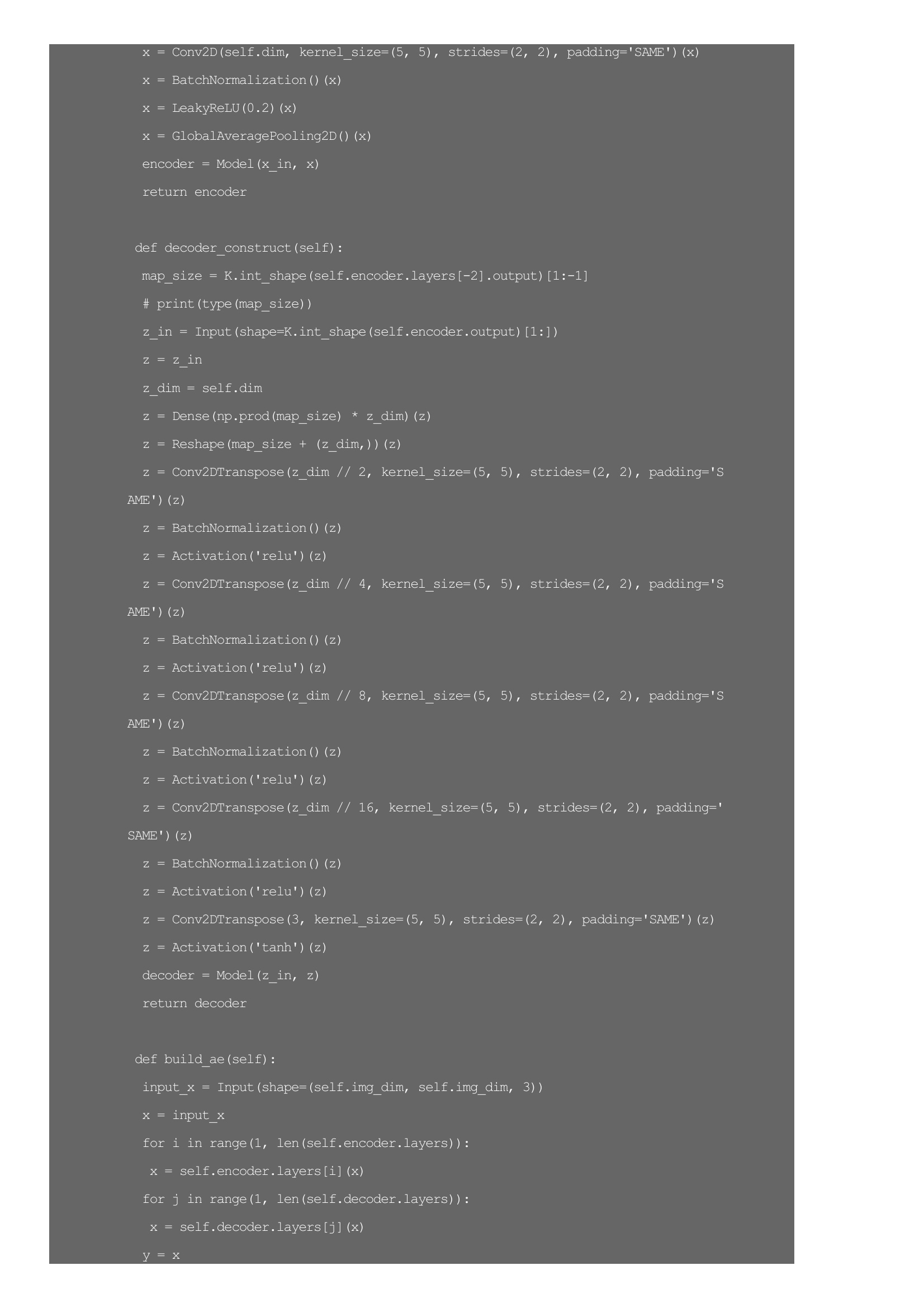

神经网络玩得越久就越会尝试一些网络结构上的大改动。将两个小模型连接成一个大模型,A-B,既可以同时训练又可以分离训练。所以,应用范围还是挺广的。首先说明,我的实现方法不一定是最佳方法。也是实在没有借鉴到比较好的方法,所以才自己手动写了一个。所以,连接的精髓在build_ae()函数,直接用for循环读出各层,然后一层一层重新构造新的模型,从而实现连接效果。因为keras也是基于图的框架,这个操作并不会很费时,因为没有实际地计算。使用keras搭建好一个模型,训练好,怎么得到每层的系数呢:这样系数就被存放到一个np中了。

暂无评论